AI领域的语言模型竞赛日趋白热化,尤其在编程辅助方面表现突出。

Gemini 2.5 Pro和Claude 3.7 Sonnet作为该领域的佼佼者,本文通过一系列编程测试与基准评估对两者的编码功能进行对比分析。

核心结论:• Gemini 2.5 Pro在SWE Bench硬核编程测试中以63.8%的通过率略胜Claude 3.7 Sonnet的62.3%。

• 两款模型在完成不同类型编程任务时各具优势与局限,Gemini 2.5 Pro在生成代码解决方案时往往更精准快速。

• 实际选择需根据项目需求及具体编程任务类型而定。

Gemini 2.5 Pro 概述尽管发布已有时日,Gemini 2.5 Pro 凭借其升级的推理分析能力持续引发热潮。该功能原本仅限Gemini Advanced订阅用户专享,如今已向大众免费开放。

虽为新秀,Gemini 2.5 Pro 已在部分测试中超越ChatGPT 4等对手(但编程和多轮对话领域除外)。

令人意外的是,在"人类终极考试"测试中,其未启用网络搜索功能的版本竟超越了OpenAI的深度研究模型,创下惊人成绩。

编程挑战测试为评估Gemini 2.5 Pro与Claude 3.7 Sonnet的编程能力,我们对两款模型进行了系列编码任务测试,结果概要如下:

1. 飞行模拟器要求:使用JavaScript开发简易飞行模拟器,需包含可从平面跑道起飞的基础飞机模型。飞机运动需通过键盘输入控制(如方向键或WASD键),并需生成类似《我的世界》风格的方块建筑构成基础城市景观。

Gemini 2.5 Pro 的表现:

成功生成了可运行的飞行模拟器代码。生成的代码完全正确,飞机操控流畅,城市景观渲染准确。

const plane = document.createElement('div');

plane.style.position = 'absolute';

plane.style.left = '50%';

plane.style.bottom = '10px';

plane.style.width = '50px';

plane.style.height = '20px';

plane.style.background = 'gray';

document.body.appendChild(plane);

document.addEventListener('keydown', (event) => {

if (event.key === 'ArrowUp') {

plane.style.bottom = `${parseInt(plane.style.bottom) + 10}px`;

}

if (event.key === 'ArrowDown') {

plane.style.bottom = `${parseInt(plane.style.bottom) - 10}px`;

}

});

Claude 3.7 Sonnet 的表现:

生成的示例代码质量堪忧,从糟糕的飞机操控到拙劣的城市渲染都问题重重。即便根据提示进行优化,也未能改善任何问题。

const plane = document.createElement('div');

plane.style.position = 'fixed';

plane.style.left = '45%';

plane.style.bottom = '5%';

plane.style.width = '60px';

plane.style.height = '25px';

plane.style.backgroundColor = 'blue';

document.body.appendChild(plane);

document.addEventListener('keydown', (event) => {

switch(event.key) {

case 'w': plane.style.bottom = `${parseInt(plane.style.bottom) + 15}px`; break;

case 's': plane.style.bottom = `${parseInt(plane.style.bottom) - 15}px`; break;

}

});

测试结论:在本项测试中,Gemini 2.5 Pro 以更真实精准的解决方案完胜 Claude 3.7 Sonnet。

2. 魔方求解器题目:编写JavaScript代码来展示并求解3x3魔方。代码需以3D形式展示魔方,并逐步显示解法步骤。

Gemini 2.5 Pro的解决方案:

成功生成了完整代码,准确呈现了3D魔方模型,并展示了正确的解法步骤。

from rubik_solver import utils

cube_state = 'RRRRRRRRRBBBBBBBBBOOOOOOOOOGGGGGGGGGYYYYYYYYYWWWWWWWWW'

solution = utils.solve(cube_state, 'Kociemba')

print(solution)

Claude 3.7 Sonnet的表现:

给出的解答存在错误,不仅颜色显示不正确,也无法正确求解魔方。即便多次补充提示,模型仍无法修正这些错误。

def solve_rubiks_cube():

moves = ['U', 'R', "L", "B", "F", "D"]

solution = []

for i in range(10):

solution.append(random.choice(moves))

return solution

print(solve_rubiks_cube())

测试结论:Gemini 2.5 Pro在本轮测试中表现更优,提供了正确且视觉效果出色的图形化解法方案。

性能基准测试基准测试数据显示,Gemini 2.5 Pro在除一个类别外的所有项目中均占据领先地位。

其在AIME测试中以30%的优势超越Claude 3.7 Sonnet,在GPQA测试中以84%对68%的比分胜出。

某财富500强运输公司于2025年3月部署Gemini 2.5 Pro进行路线优化,报告显示实现了15%的燃油消耗降低、22%的准时交付率提升,以及年均350万美元的成本节约。

最终结论在编程助手领域,Gemini 2.5 Pro与Claude 3.7 Sonnet都展现出卓越实力。

两者表现皆属顶尖,但Gemini 2.5 Pro在应对高难度编程问题及考试场景时更具优势。其出色的性能表现,使其成为需要顶级编程辅助的开发者的理想之选。

转载请注明出处: CHATWEB

本文的链接地址: https://chatweb.com.cn/post-168.html

-

开抢!腾讯官宣 28000 HC!

5天前

-

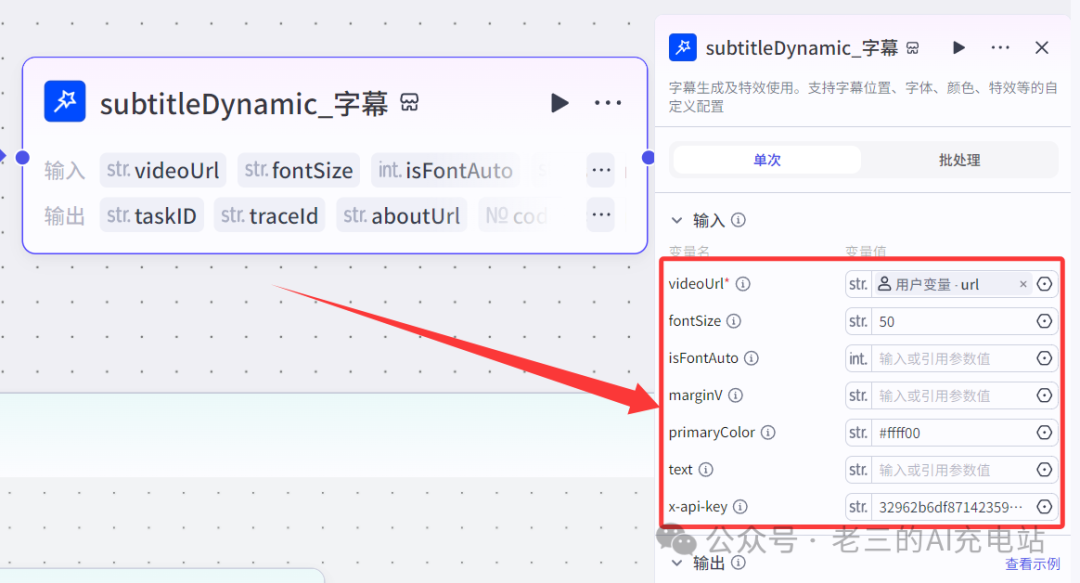

扣子(coze)实战 | 用coze一键打造自己的口播数字人,操作简单方便(包含coze网页登录、声音克隆、数字人制作)

2025/04/19

-

深藏不露!Kimi这8个隐藏用法,高手都偷偷收藏了,再不学习就晚了!(上)

6天前

-

我用AI「 高德 MCP+ cursor」 解决了日常最大难题“吃什么”!5分钟就搞定吃什么!

2025/04/19

-

![[AI工具箱] OneLine:一个由AI优化的时间线工具,如何帮你高效『吃瓜』?](https://chatweb.com.cn/content/templates/beginning_pro/static/images/loading.svg)

[AI工具箱] OneLine:一个由AI优化的时间线工具,如何帮你高效『吃瓜』?

5天前

-

华为电脑管家接入了四家大模型,却是“果篮式”的拼凑

2025/04/19

-

28000个实习岗位,腾讯发起史上最大就业计划

5天前

-

一文全懂:最牛AI公司OpenAI公司治理权斗背后的最创新股权设计

6天前

-

扣子(Coze)怎么搭建工作流?

2025/04/19

-

Kimi 16B胜GPT-4o!开源视觉推理模型:MoE架构,推理时仅激活2.8B

6天前

AI资讯网小编

AI资讯网小编

![[AI工具箱] OneLine:一个由AI优化的时间线工具,如何帮你高效『吃瓜』?](https://chatweb.com.cn//content/uploadfile/x_wxgzh/20250421/6805c4e998ffc.jpg)

EMLOG

EMLOG

暂无评论